De gemeente Nissewaard heeft in korte tijd flinke stappen gezet om een meer datagedreven organisatie te worden. Het begon in de zomer van 2024 als pilot om met behulp van Power BI meer inzicht in de Jeugdzorg en Wmo te krijgen. En nu staat binnen een jaar het fundament voor de gehele organisatie om dataprojecten uit te voeren. De gemeente Nissewaard neemt je mee hoe zij dat voor elkaar hebben gekregen.

Klein beginnen

Rody van Oudheusden – Senior Adviseur Sociaal Domein vertelt:

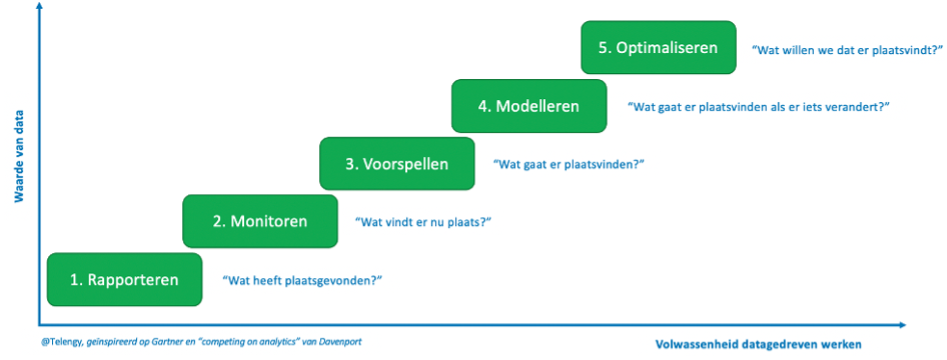

“Door de ontwikkelingen binnen het sociaal domein op Jeugd en Wmo ontstond er vanuit verschillende rollen in de organisatie een steeds grotere behoefte aan actuele inzichten. We gebruikten hier meerdere middelen voor, maar misten een integraal en flexibel dataplatform. Via een pilot wilden we testen of we met Power BI een stap konden zetten. We zijn hierbij met een klein team begonnen en met een beperkte scope. Met ondersteuning van 3-DM die de data analist en data engineer leverde en projectbegeleiding van Telengy hadden we binnen twee maanden de eerste positieve resultaten en zagen we de potentie van de rapportages en visualisaties waarbij we met enkele kliks van totalen op wet-niveau, konden inzoomen op productniveau, kosten en cliënten.”

Opschalen – van pilot naar fundament

Mohamed Laghzaoui – Chief Information Officer legt uit:

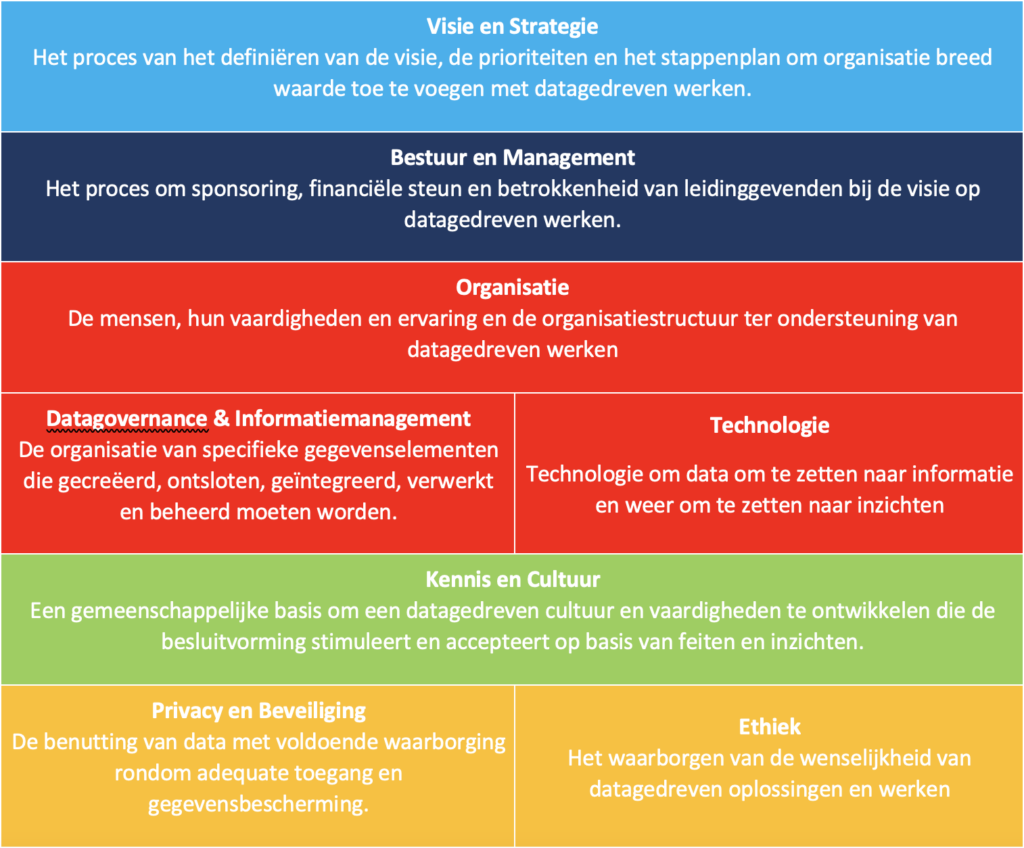

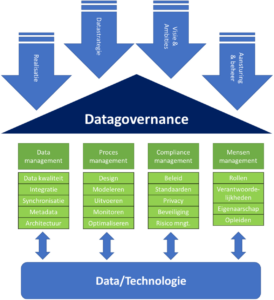

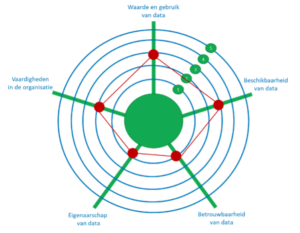

“Na de geslaagde pilot beseften we ons dat we door moesten pakken. We zijn gaan opschalen om een fundament te leggen voor de hele organisatie. Wat we daarin als Nissewaard in een half jaar hebben bereikt, is bijzonder. Simultaan is gewerkt aan een concreet eindproduct voor het sociaal domein, is een technisch platform neergezet en zijn organisatorische randvoorwaarden ingericht.

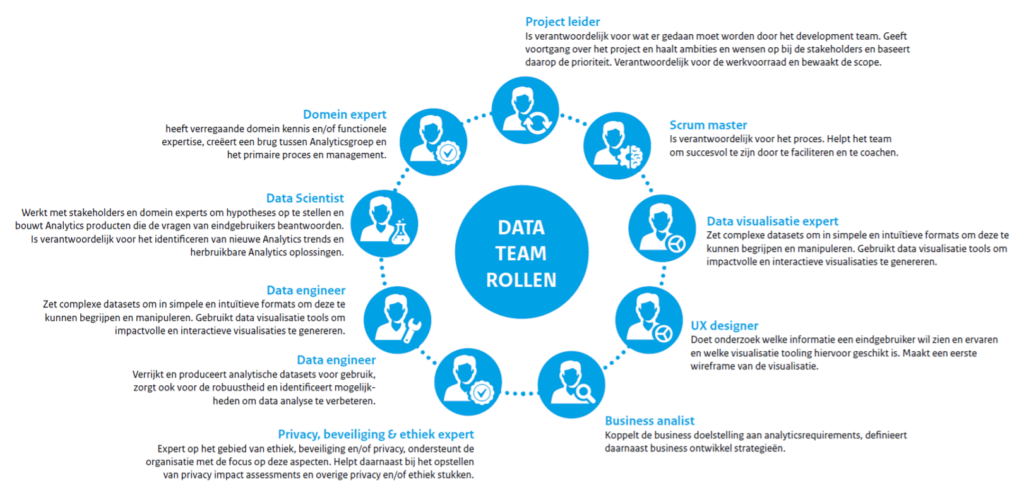

Het technische platform is inmiddels productiewaardig, in beheer genomen, en ons interne datateam is opgeleid om zelf data-producten te bouwen en beheren. Dankzij de begeleiding van Telengy en de technische expertise van 3-DM hebben we niet alleen een eerste succes neergezet, maar ook structureel gebouwd aan onze eigen kracht.

Dit project is daarmee niet het eindpunt, maar het vertrekpunt voor een organisatie die haar keuzes baseert op betrouwbare, actuele inzichten.

Deze beweging was alleen mogelijk dankzij het brede draagvlak binnen de organisatie. We hebben vanaf het begin de steun en betrokkenheid gevoeld van het Centraal Management Team (CMT), dat het belang van datagedreven sturing vanaf dag één heeft onderkend. Die strategische steun gaf het project de ruimte én het mandaat om te groeien. Zo werd het geen losstaand initiatief, maar een gedeeld organisatiebelang. Wat mij het meest trots maakt, is dat we in korte tijd samen een stevig fundament hebben neergezet dat werkt en dat enthousiasme en beweging in de hele organisatie losmaakt. Dit is geen losstaand IV-project gebleven, maar een strategische stap richting een datagedreven manier van werken en sturen. De eerste successen in het sociaal domein hebben laten zien wat er mogelijk is, en nu ligt er een basis waar we op voort kunnen bouwen.”

Doorontwikkelen

Rody vertelt over de doorontwikkeling:

“We zijn best trots op waar we nu na een klein jaar staan, want uiteindelijk is het een brede beweging geweest met een goede samenwerking tussen IV en business waarbij we niet alleen voor het sociaal domein maar voor de hele organisatie een goede technische en organisatorische basis hebben neergezet. We zijn er alleen nog niet. Doorontwikkeling richting eindgebruikers is een volgende stap waarmee we de komende tijd echt waarde kunnen creëren. Continue samenwerking tussen onze teams in het sociaal domein en het datateam is hierin ontzettend belangrijk. Alleen dan krijgen we voor elkaar dat we ons beleid, de processen en onze dienstverlening gerichter kunnen optimaliseren op basis van datagedreven besluiten.”

En Mohamed vult aan:

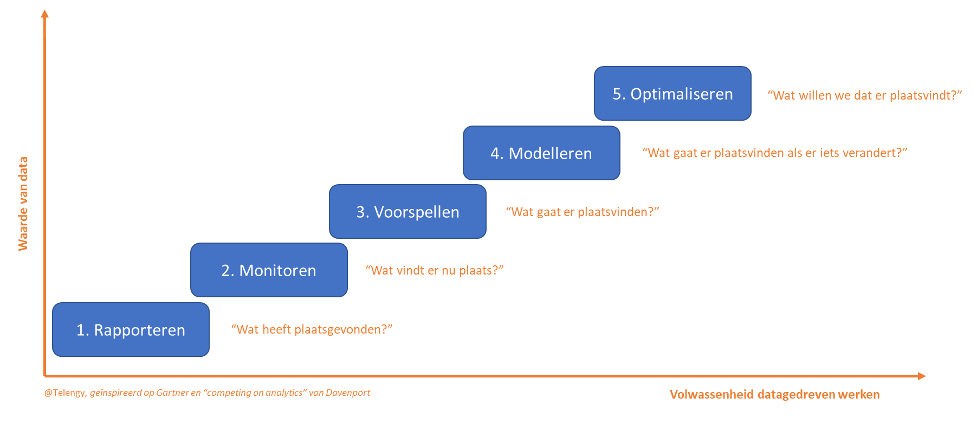

“Onze focus ligt nu op het vergroten van die olievlek: steeds meer domeinen willen aansluiten, van HR tot vastgoed, van veiligheid tot financiën. We willen met Telengy, 3-DM en ons interne datateam kijken naar voorspellende analyses (forecasting). Denk aan het tijdig signaleren van trends in jeugdzorgaanvragen of het voorspellen van toekomstige zorgdruk. Daarmee verschuiven we van terugkijken naar vooruitkijken. Ook willen we de eerste stappen richting het verantwoord toepassen van kunstmatige intelligentie (AI). Daarnaast verkennen we hoe we geselecteerde datasets beschikbaar kunnen stellen als open data zodat inwoners, partners en onderzoekers ook waarde uit onze data kunnen halen.

Deze beweging kan alleen slagen als je het samen doet. De hulp die we hebben gekregen was noodzakelijk om in beweging te komen. Maar minstens zo belangrijk is de betrokkenheid van onze eigen collega’s geweest: samen bouwen we aan een gemeente die niet langer op onderbuikgevoel stuurt, maar op inzicht. En dat is randvoorwaardelijk in een wereld waarin wendbaarheid, transparantie en maatschappelijke legitimiteit steeds belangrijker worden. Ik zie daarom de toekomst met vertrouwen tegemoet. Niet alleen omdat we de technologie op orde hebben, maar vooral omdat we als organisatie in beweging zijn. We hebben het fundament gelegd, nu bouwen we door.”

Meer weten?

Voor meer informatie kun je contact opnemen met Tim van der Pol via de contactpagina.